一、Qwen3 核心功能特性:重新定义开源大模型天花板

1.混合推理架构:快思考与慢思考的完美融合

Qwen3 首创「混合推理模式」,将人类认知科学中的「双系统理论」注入 AI 设计。

- 思考模式:面对复杂数学推导(如 AIME25 测评 81.5 分)、代码生成(LiveCodeBench 评测 70 分)等任务时,模型会通过多步骤推理输出详细过程,支持最高 38k token 的动态思考预算。开发者可通过/think指令逐轮控制模式,甚至在多轮对话中无缝切换。

- 非思考模式:在简单问答、对话交互场景下,模型可实现毫秒级响应,推理成本仅为思考模式的 1/5。通过/no_think指令禁用深度推理,显著提升交互效率。

- 动态切换:模型会根据任务复杂度自动分配计算资源,例如在金融风险评估中,复杂逻辑链触发思考模式,而常规查询则进入非思考模式,整体算力消耗降低 40%。

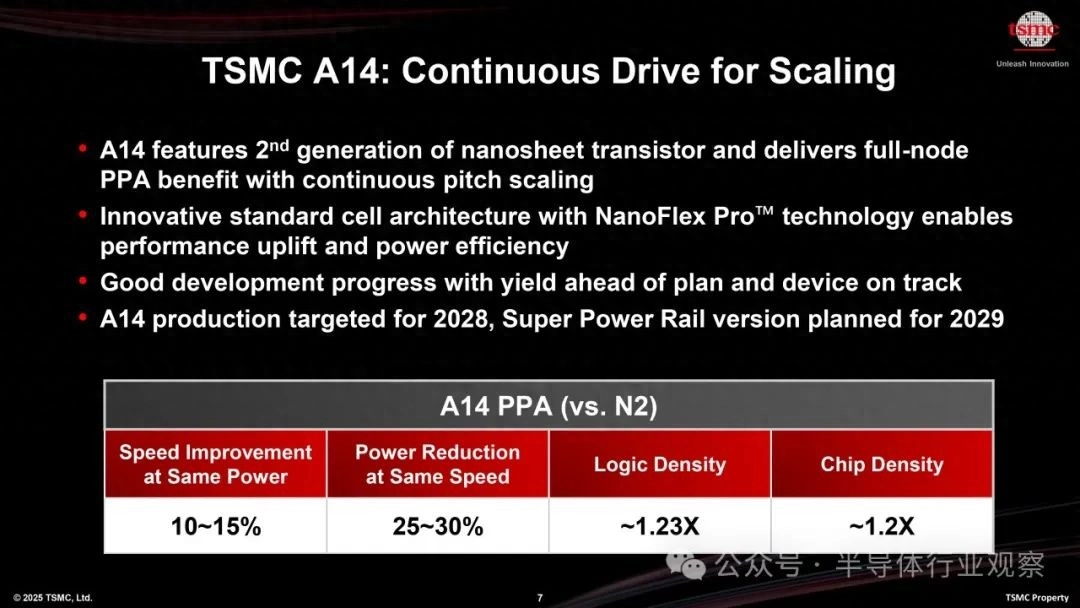

2.MoE 架构革命:参数效率的史诗级突破

旗舰模型 Qwen3-235B-A22B 采用混合专家(MoE)架构,总参数量 2350 亿,但每次推理仅激活 220 亿参数:

- 性能碾压:在数学、代码、通用能力基准测试中,超越 DeepSeek-R1、OpenAI-o1 等模型,逼近谷歌 Gemini-2.5-Pro。例如,Qwen3-235B-A22B 在 AIME25 测评中以 81.5 分刷新开源纪录,代码生成能力超越 Grok3。

- 成本暴跌:部署成本仅为 DeepSeek-R1 的 25%-35%,显存占用降低至 1/3,4 张 H20 显卡即可运行满血版。小型 MoE 模型 Qwen3-30B-A3B 激活参数仅为 QwQ-32B 的 10%,性能却更优。

- 架构创新:MoE 模型动态激活参数,Dense 模型参数效率提升 50%。例如,Qwen3-32B 性能超越 Qwen2.5-72B,而参数量仅为其一半。

3.多语言与 Agent 能力:全球化与智能化的双重跃迁

- 119 种语言支持:覆盖印欧语系、汉藏语系等小众语言(如粤语、斯瓦西里语),实现跨语言对话、翻译的无缝衔接。例如,Qwen3-235B-A22B 可自动识别用户语言并切换响应模式。

- Agent 增强:在 BFCL 评测中得分 70.8,支持 MCP 协议和 Qwen-Agent 框架,可自动调用 API、执行代码。通过 Qwen3-235B-A22B 可一键完成 GitHub 项目分析、生成可视化图表,降低智能体开发门槛。

4.全尺寸模型矩阵:从手机到云端的全场景覆盖

Qwen3 开源 8 款模型,形成「轻量 – 企业 – 云端」的完整生态:

- 端侧部署:0.6B/1.7B 模型支持手机 APP,4B 模型适配车载场景。例如,Qwen3-4B 在手机端可实时翻译、生成代码。

- 企业级应用:8B/14B/32B 模型在数据分析、流程自动化中表现优异,性能较前代提升 50%。Qwen3-32B 可跨级超越 Qwen2.5-72B,适合大规模企业部署。

- 云端旗舰:235B-A22B MoE 模型在超算中心实现千亿级参数推理,支持 128K 超长上下文,满足科研和金融等领域的复杂需求。

二、Qwen3 的颠覆性优势:开源界的「降维打击」

1.性能超越闭源模型,成本仅为 1/3

- 数学能力:在 AIME25 测评中,Qwen3-235B-A22B 以 81.5 分刷新开源纪录,逼近 Gemini-2.5-Pro 的 86.7 分。

- 代码生成:LiveCodeBench 评测突破 70 分,超越 Grok3,适合复杂软件工程开发。

- 人类对齐:ArenaHard 测评 95.6 分,超越 OpenAI-o1,生成内容更符合人类偏好。

2.训练与架构创新:36 万亿 token 的「暴力美学」

- 数据规模:预训练数据达 36 万亿 token,是 Qwen2.5 的两倍,涵盖 PDF 文档解析、STEM 教材、代码合成数据。通过 Qwen2.5-Math 和 Qwen2.5-Coder 生成合成数据,提升数学和代码能力。

- 四阶段训练:通过长思维链冷启动、强化学习、模式融合、通用优化,模型在推理与响应间实现完美平衡。例如,在 STEM 领域,Qwen3 Dense 模型性能优于更大的 Qwen2.5 模型。

- 架构优化:MoE 模型动态激活参数,Dense 模型参数效率提升 50%。例如,Qwen3-32B 性能超越 Qwen2.5-72B,而参数量仅为其一半。

3.开源生态与政策适配:国产模型的「突围之路」

- 免费商用:全系列模型采用 Apache 2.0 协议,企业可直接用于商业项目。

- 政策友好:支持中文、阿拉伯语等非英语场景,契合「一带一路」市场需求。例如,Qwen3-235B-A22B 可自动识别阿拉伯语并生成符合当地政策的内容。

- 工具链完善:与 Hugging Face、vLLM、Ollama 等框架深度兼容,提供 Qwen-Agent 开发套件。开发者可通过 Qwen-Agent 快速构建智能体,降低编码复杂性。

三、抢先使用 Qwen3 的五大攻略

1.快速体验:无需代码的云端入口

- 通义千问官网:访问https://chat.qwen.ai,直接切换「思考模式」与「非思考模式」。输入/think触发深度推理,/no_think快速响应。

- 通义 APP:移动端支持语音交互,可实时翻译、生成代码。例如,在通义 APP 中输入 “写一个 Python 爬虫”,模型会自动生成代码并解释逻辑。

- 模力方舟:在线体验 Qwen3-30B-A3B,支持流式输出和多轮对话。例如,在模力方舟中输入 “分析 GitHub 项目性能瓶颈”,模型会调用工具链自动分析并生成报告。

2.开发者部署:从本地到云端的全路径

- 本地部署:

# 使用Ollama快速启动

ollama run qwen3:30b-a3b

# 使用LMStudio加载模型

llama.cpp -m Qwen3-30B-A3B.gguf -p "写一个Python爬虫"- 云端服务:

python

# 通过vLLM部署API

from vllm import LLM

llm = LLM(model="Qwen/Qwen3-30B-A3B", enable_reasoning=True)

outputs = llm.generate("如何优化MoE模型推理效率?")3.企业级应用:智能体与行业解决方案

- Qwen-Agent 框架:

python

from qwen_agent import QwenAgent

agent = QwenAgent(tools=["git_clone", "data_analysis"])

agent.run("分析GitHub项目性能瓶颈")4.学术研究:开源模型的深度挖掘

- 微调指南:

python

from peft import LoraConfig, get_peft_model

model = AutoModelForCausalLM.from_pretrained("Qwen/Qwen3-14B")

peft_config = LoraConfig(r=8, lora_alpha=32, target_modules=["q_proj", "v_proj"])

model = get_peft_model(model, peft_config)- 评测工具:使用qwen-eval库复现 AIME25、LiveCodeBench 等测评。例如,在终端输入qwen-eval –model Qwen3-235B-A22B –benchmark AIME25即可运行测评。

5.注意事项:避坑与最佳实践

- 思考预算控制:避免在简单任务中过度推理,例如设置max_reasoning_tokens=1024。

- 显存优化:4bit 量化模型(如 Qwen3-235B-A22B)在 M2 Ultra 上可流畅运行。

- 内容安全:通过/filter指令启用敏感词过滤,符合《生成式 AI 服务管理办法》。

四、总结:Qwen3 如何改变 AI 格局?

Qwen3 的发布标志着国产大模型从「跟跑」转向「并跑」:

- 性能层面:235B MoE 模型在数学、代码领域超越 DeepSeek-R1,逼近闭源顶尖水平。

- 成本层面:部署成本降至同类模型的 1/3,显存占用降低至 1/3,加速 AI 普惠。

- 生态层面:开源 200 余个模型,全球下载量超 3 亿次,衍生模型数突破 10 万。

无论是开发者、企业还是研究者,Qwen3 都提供了「性能 – 成本 – 灵活性」的最优解。现在,立即行动,抢占 AI 开源生态的制高点!

本文转自头条号AI码力

© 版权声明

文是楼上发的,图是楼上帖的,寻仇请认准对象。

有些是原创,有些图文皆转载,如有侵权,请联系告知,必删。

如果不爽,请怼作者,吐槽君和你们是一伙的!请勿伤及无辜...

本站所有原创帖均可复制、搬运,开网站就是为了大家一起乐乐,不在乎版权。

对了,本站小水管,垃圾服务器,请不要采集,吐槽君纯属用爱发电,经不起折腾。

THE END

暂无评论内容